Aufbau eines Data Teams

zurück zur Übersicht

[06.02.2023]

„Data is the new oil” ist ein Zitat eines britischen Mathematikers aus dem Jahre 2006. Da Daten, also Informationen, in einer agilen Welt immer wichtiger werden, ist dies auch heute noch hochaktuell. Raw Data, auf Deutsch rohe/unraffinierte Daten liefern jedoch kaum Erkenntnisse. Daher ist es wichtig ein Data Team zu haben das aus den Rohdaten Transparenz & Wertschöpfung generieren kann.

1. Welche Rollen gibt es in einem Data Team:

Klassisch lässt sich ein Data Team in drei Rollen unterteilen:

- Der Data engineer: Er ist dafür zuständig Data Pipelines zu bauen, d.h. verschiedene Quellsysteme automatisiert anzubinden und in ein Data warehouse (DWH) zu integrieren. Dabei liegt die Kunst darin mit unterschiedlichen Datenquellen umzugehen (APIs, Dateien aka. Flat files, Datenbanken, Web scrapping etc.) und die Data Pipelines so zu konstruieren, dass sie robust gegenüber möglichen Fehlern sind. Dies ist umso schwerer, wenn sich die Daten(-struktur) der Quellsysteme ändern kann. Daher empfehlen wir Excel auch nicht als Quelle für Daten (siehe Blogpost Excel vs. DB). Generell erhöht sich die Komplexität des Aufgabenbereichs, wenn es um Echtzeitdaten geht anstatt z.B. täglich aktualisierte Daten (Stichwort: Streaming vs. Batch processing).

- Der Data analyst: Typischerweise nutzt der Analyst Datenquellen, die es bereits im Unternehmen/DWH gibt und wertet diese aus. Dazu gehört sowohl die Konzeptionierung der Auswertung, die Visualisierung und die Nutzungsbereitstellung. Je nach Auslegung der Rolle sollte ein Analyst auch das Fachwissen des Bereichs innehaben für die er die Daten analysiert.

- Der Data scientist: Für komplexe Zusammenhänge, die nicht „einfach“ logisch abzubilden sind bzw. der logische Zusammenhang noch unbekannt ist, kann es sich anbieten Data science Modelle zu nutzen. Hier kann der Data scientist zwischen einer Vielzahl von Modellierungsansätzen wählen und diese anwenden. Ebenso wie der Data analyst nutzt er hier vorhandene Datenquellen innerhalb des Unternehmens.

*Mit neuen Daten interagiert zuerst der Data engineer, da er sie in das DWH integriert. Meist werden diese dann vom Data analyst genutzt um diese Daten z.B. täglich automatisiert und analysiert bereit zu stellen. Der Data scientist kann diese Daten ebenfalls täglich nutzen, allerdings kann es, je nach Modellierung und Aufbau, auch Sinn machen nur bestimmte Daten auszuwerten (z.B. bei einmaligen Analysen zu punktuellen Events).

2. Wer ist für die Qualität der Daten verantwortlich?

Diese Frage ist Unternehmensabhängig und meist von Datenquelle zu Datenquelle unterschiedlich. Im besten Fall werden die Daten dort bereinigt, wo sie anfallen, im Quellsystem. Dafür müssen die Dateneingabeprozesse angepasst werden und die Verantwortlichkeit für die Qualität der Daten liegt somit bei den Prozessverantwortlichen oder den Systemverantwortlichen.

Dies ist bei externen Quellen schwer umsetzbar. In solchen Fällen empfiehlt es sich die Daten soweit „oben“ wie möglich in der Data Pipeline zu bereinigen (im englischen nennt man dies upstream), also bei oder nach dem Einspielen in das DWH. In größeren Unternehmen gibt es dafür spezielle Rollen, sogenannte Data Stewards die bestimmte Datenquellen verantworten und u.a. für die Datenqualität einstehen.

3. Wer stellt die Daten-Infrastruktur?

Hierbei handelt es sich um Datenspeicherung, -integration, -verarbeitung und Prozessautomatisierung. Je nach Tool-Landschaft gibt es hier die unterschiedlichsten Anforderungen von Datenbanken über virtuelle Maschinen und spezieller Software. Typischerweise sollte dies von der IT-Abteilung bereitgestellt werden.

Je nach Größe und Kompetenz kann dies aber auch vom Data Team übernommen werden. Gerade Cloud basierte Datenbankdienste erleichtern kleinen Unternehmen die Administrierung und Verwaltung von Datenbanken. So können Data Teams ihre eigenen Datenbanken innerhalb von Minuten aufsetzen und nutzen.

4. Viele Begrifflichkeiten erschweren den Umgang

Im Data Bereich gibt es verschiedenste Jobbezeichnungen und gefühlt kommen jedes Jahr weitere hinzu. Dies liegt u.a. daran, dass es im Data Bereich ständig neue Technologien und Ansätze gibt, die es ermöglichen leichter größere Datenmengen zu speichern, zu integrieren und zu analysieren.

So gibt es mittlerweile hoch performante Cloud Datenbankdienste wie Snowflake, Google Cloud, AWS oder Azure als auch online basierte Integrationsdienste wie Fivetran oder Matillion.

Damit einhergehend gibt es neue Jobbezeichnungen wie cloud engineer, machine learning engineer, business intelligence analyst, web analyst, analytics engineer und viele mehr.

Dabei handelt es sich im Kernteil um Spezialisierungen der initial drei genannten Data Rollen. Der analytics engineer ist z.B. ein Mix aus Data engineer und analyst.

Des Weiteren werden diese Bezeichnungen oft nicht genau definiert und von Unternehmen zu Unternehmen anders interpretiert und gelebt was es schwieriger macht Rollen zu vergleichen.

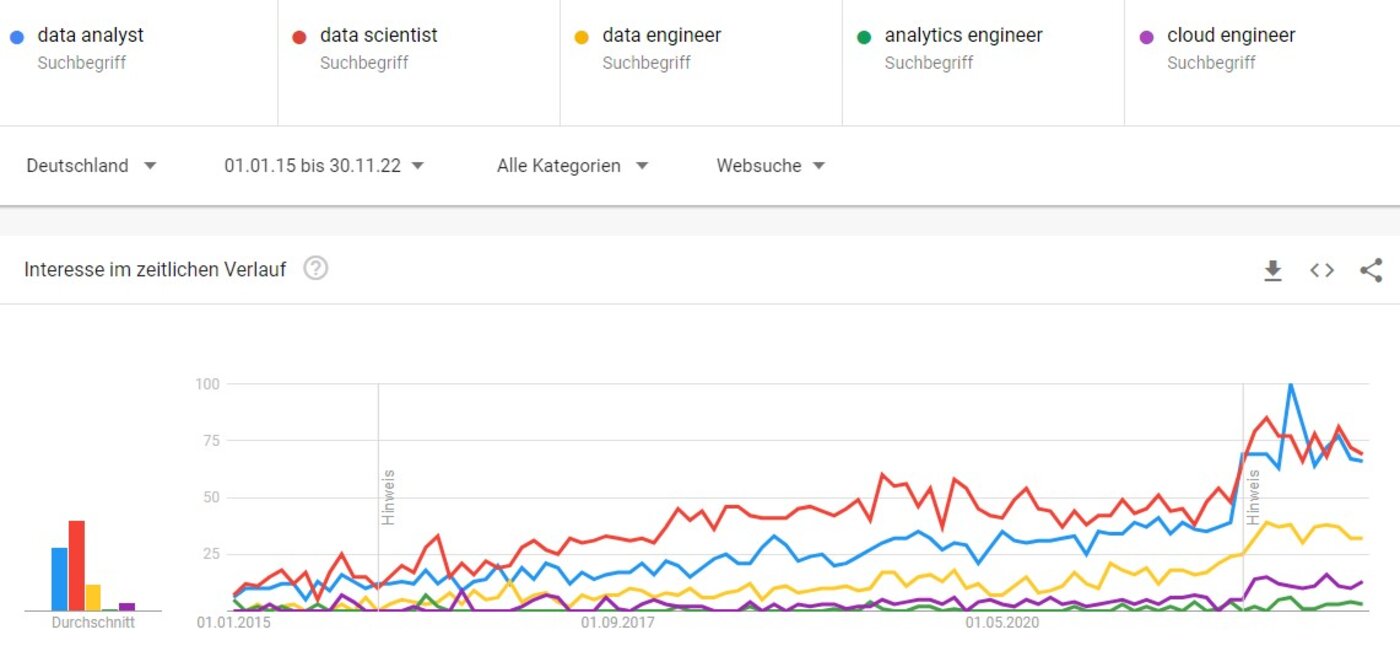

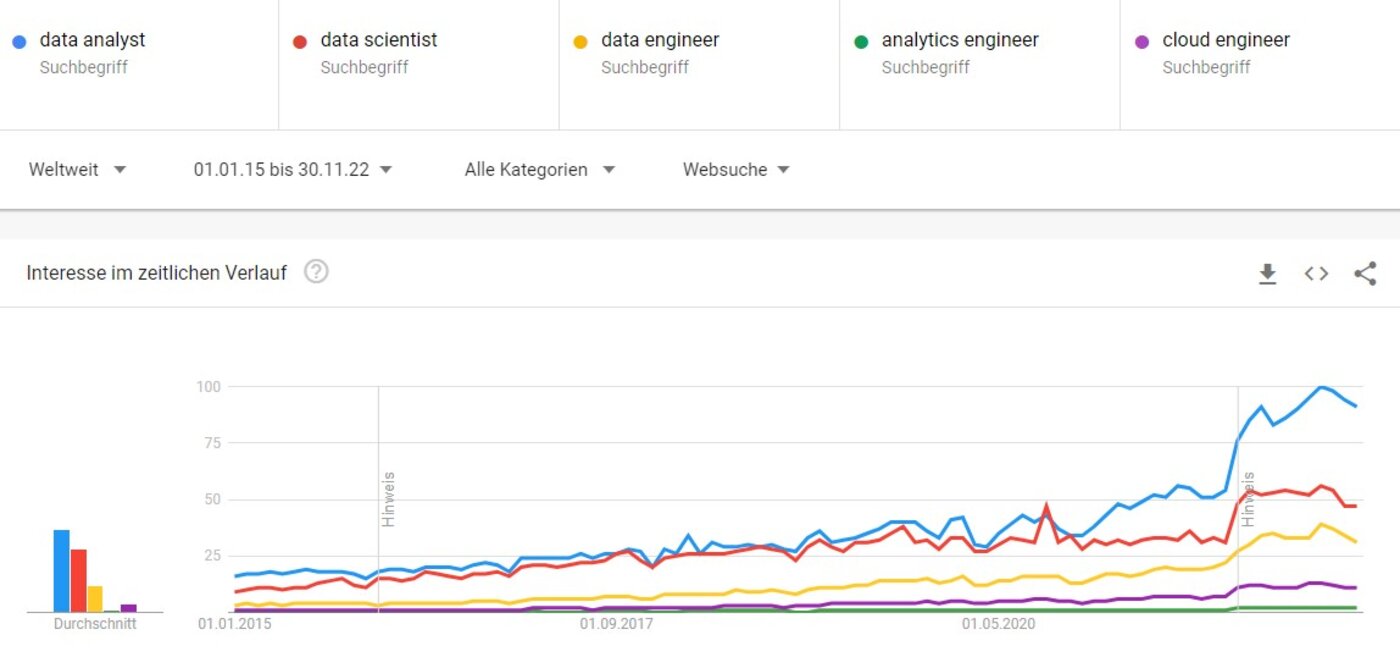

Interessehalber hierzu zwei Screenshoots aus Google Trends zu fünf verschiedenen Data Rollen um ein Gefühl für die Popularität der Rollen zu bekommen.

Für die Google-Trends-Neulinge: Google Trends normiert die Ergebnisse innerhalb des Suchraums auf einen Wert zwischen 1 und 100 wobei 100 der maximale Höchstwert innerhalb des Suchraums ist.

Jobbezeichnungen in Deutschland vom 01.01.2015 bis zum 30.11.2022:

(Link zu Google Trends -> Jobbezeichnungen in Deutschland vom 01.01.2015 bis zum 30.11.2022)

Und respektiv die gleiche Suche weltweit:

(Link zu Google Trends -> Jobbezeichnungen weltweit vom 01.01.2015 bis zum 30.11.2022)

Wie erwartet steigen die Anzahl der Suchen mit der Zeit, approximierbar linear an. Auch nicht überraschend ist, dass der data scientist tendenziell in Deutschland öfter gesucht wird, während in Amerika der data analyst führt. Dies liegt wahrscheinlich daran, dass der Begriff data science relativ populär in den hiesigen Medien aufgegriffen wurde.

5. Kompetenz:

Wie auch immer nun die Jobbezeichnungen sein mögen – wer Daten analysieren und auswerten will, sollte ein Team, oder einen Technologiepartner haben, der zumindest die ersten beiden, im besten Fall alle drei, Kernkompetenzen eines Data Teams innehat. Je nach Projekt erachten wir zumindest die Fähigkeiten eines data engineers und -analysts als notwendig um z.B. DWH basierte Reporting Projekte zu realisieren. Hierfür stehen wir als Technologiepartner oder Sparringspartner gerne zur Seite.

Autor Maximilian Löffel

Mehr über Maximilian Löffel